您现在的位置是:首页 > 特别推荐 >

超过人类水平!网易伏羲中文预训练模型玉言登顶FewClue榜单

2021-12-31 11:42:52作者:来源:IT运维网

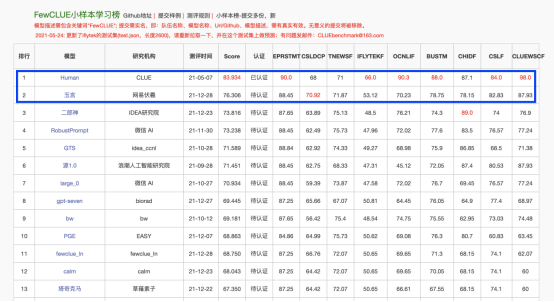

摘要近日,网易伏羲在中文语言理解权威评测基准FewClue榜单登顶,在IFLYTEK(长本文分类 )、CLUEWSC(代词消歧)、CSL(论文关键词识别)、CSLDCP ...

据了解,FewCLUE是CLUE推出的一项中文小样本学习评测榜单,用来评估预训练模型是否能够通过小样本学习来掌握特定的自然语言处理任务。同时,研究人员也可通过相关测试评估AI模型再学习能力和快速应用能力。而从结果来看,网易伏羲的模型玉言对中文的理解能力,已经接近甚至在部分任务上超过一个受过相关训练的人类。

更值得一提是,玉言具备的自然语言处理能力可应用于语音助手、智能客服、新闻传媒、游戏创作、智能决策等领域。而在获得这些能力背后的模型训练体系及应用方法则验证了基于超级模型进行二次训练和快速应用的可能性。在目标领域通过少量标注样本极大的提升应用的效果,从而节省大量的人力成本。

人工智能研究的诞生到现在已经有60多年的历史,近些年的深度学习掀起了人工智能的新一波浪潮。OpenAI 发布的GPT系列模型将自然语言处理水平推向了新的高度,也证明了大规模预训练的潜力,为智能服务应用场景提供最重要的基石。但是,这些如雨后春笋般涌现的大规模预训练模型都是以文本生成为导向,在语义理解方面受限于其技术局限,效果不佳。

因此,业界为语义理解任务重新训练模型,例如BERT、DEBERTA等。文本生成任务和语言理解任务分别训练,这不仅是对算力和成本的巨大消耗,也不符合当下社会对低碳发展的要求。是否将预训练生成模型通过少量的二次训练转换为理解模型?玉言模型正是基于这个出发点的一次成功尝试,将生成模型通过少量的二次训练转换为高准确度的语义理解模型。更重要的是,这一方法的成功实践,能有效帮助中小企业降本节能。

据该项目团队介绍,玉言模型的前身是网易伏羲自研的50亿GPT2生成模型,通过二次训练变成语义理解能力较好的Prefix-LM,相比于原来的GPT2模型,只是attention mask形状不同,Prefix-LM可以直接使用许多开源的GPT加速库进行推断加速。

玉石二次训练的主要方法包括在Prefix部分增加MLM损失函数,同时使用增强Position Embebedding的方法去进一步强化Prefix部分的编码效果等。在任务数据集处理方面使用类似于T0的基于模板的方法,将FewClue的数据集在二次训练时混入训练语料中。

另外,FewClue提供的无标签数据同样被构造模板,处理完成后加入训练语料中。使用模板的方法可以自然地实现多任务学习,大大降低语义理解大模型的训练成本,更加有利于工程落地。“同时也非常感谢浪潮共享了他们的部分预训练文本,为玉言模型训练提供了充分的数据。”项目团队相关负责人表示。

网易伏羲成立于2017年,是国内专业从事游戏与泛娱乐AI研究和应用的顶尖机构。网易伏羲已经发表100多篇AI顶会论文,拥有200多项发明专利,以及数字人、智能捏脸、AI创作、AI反外挂、AI推荐匹配、AI竞技机器人等多个领域的领先技术。目前,网易伏羲正在向游戏、文旅、文娱等产业开放AI技术及产品,目前已服务超100家客户,应用日均调用量超数亿次。

(本文不涉密)

责任编辑:

特别策划

数智融合 聚力赋能 2023数字生态产业峰会暨第十六届信息主管年会在京召开

数智融合 聚力赋能 2023数字生态产业峰会暨第十六届信息主管年会在京召开 2023开源和信息消费大赛

2023开源和信息消费大赛 第十二届“中国软件杯”大学生软件设计大赛

第十二届“中国软件杯”大学生软件设计大赛 育名企 铸名品 创名园——创建高质量中国软件名园研讨会在渝成功召开

育名企 铸名品 创名园——创建高质量中国软件名园研讨会在渝成功召开站点信息

- 运营主体:中国信息化周报

- 商务合作:赵瑞华 010-88559646

- 微信公众号:扫描二维码,关注我们